2012年12月5日,住建部印发了《国家智慧城市试点暂行管理办法》和《国家智慧城市(区、镇)试点指标体系(试行)》两个文件,从2012年到2015年年底,各部委组织的智慧城市相关试点有近600个。但在这一轮智慧城市的建设热潮中,展现出技术主导倾向,将智慧城市建设目标等同于信息化建设,暴露出“盲目建设、重复建设、信息孤岛林立、业务缺乏协同、标准和接口各异、信息安全不受控”等现象。

伴随着物联网、移动通信、移动互联网等技术的发展和应用,社会中产生了海量的、连续的、时空相关的关于人、物体、事件的数据;结合大数据技术的发展和应用,对时空数据的分析、挖掘和利用,可帮助我们掌握事物的发展态势、关键影响因素、形成模式和发展规律,提升对物理空间和社会空间的认知和洞察;同时也可以让城市管理部门可以更准确的掌握公众和企业的需求和偏好,以便提供更为便捷的、个性化的、精准的服务。

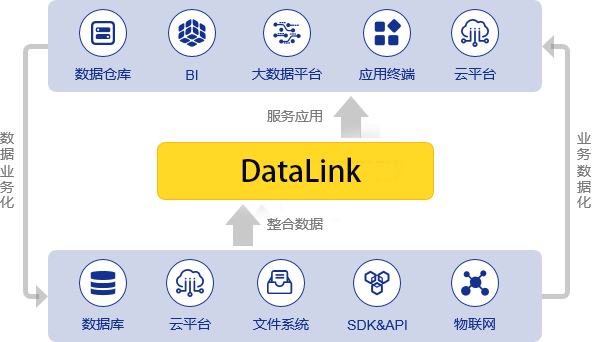

Datalink概述

DataLink作为数据同步中间件,无需任何代码,通过可视化图形配置界面即可自定义一条数据ETL任务,并通过统一的时空剖分编码,支持多源异构的时空数据传输、集成,实现了时空数据同步的分布式综合调度管控。

DataLink目前主要应用在帮助企事业单位进行多源异构时空数据融合,为用户提供高效的数据整合、查询等数据开发业务服务,通过数据抽取、编码、清洗、转换、过滤等一些系列从操作,帮助客户实现高效地连接复杂的异构数据源和目的地,大数据量高并发数据同步,帮助企业数据上云,云上时空分析提供数据业务能力的快速融合、重塑和创新的能力。

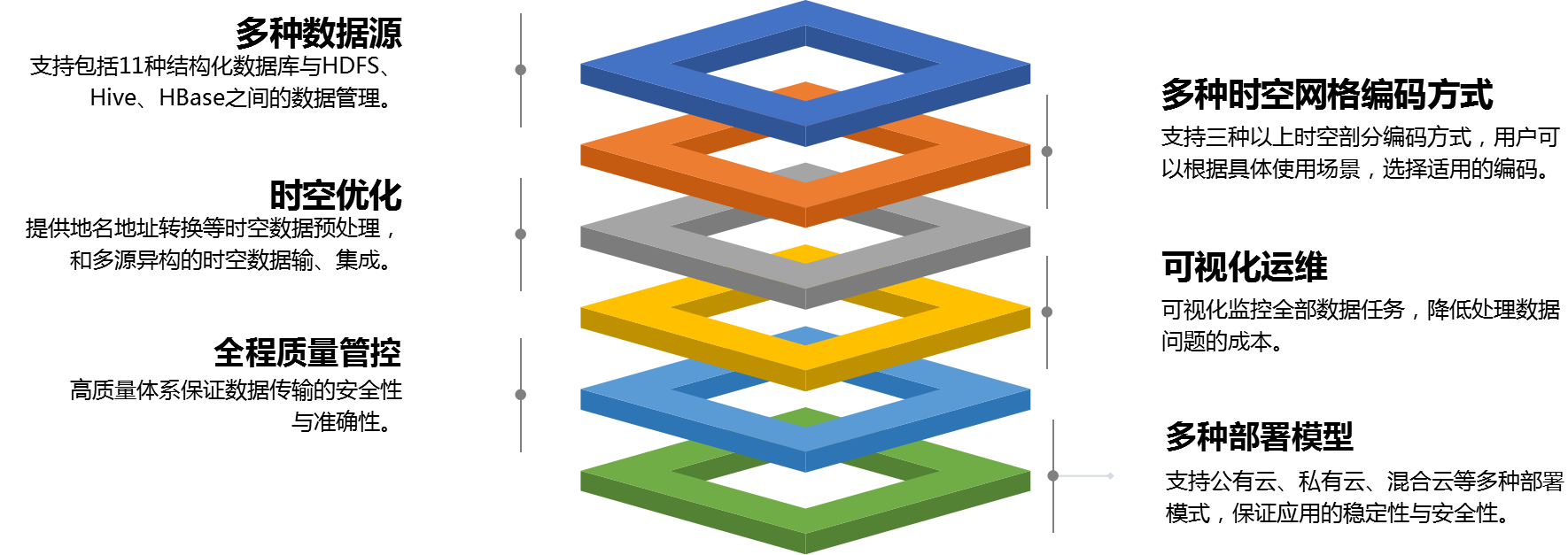

产品特色

功能介绍

数据源管理

DataLink支持包括11种结构化数据库与HDFS、Hive、Hbase等的在线数据源与离线数据源,其中通过连接在线数据源,提供可视化的数据库管理功能,用户无需切换多个工具,即可完成数据业务开发全流程。

数据集成

包含了数据处理的过程设计,分为数据的输入、处理、输出三部分,采用组件化的工作流搭建方式,可视化界面搭建整个数据集成流程,可适应不同领域的数据开发工作需求。

数据编码

DataLink支持3时空剖分编码方式,同时提供地名进行地理信息的解析,用户可以根据具体使用场景,选择适用的编码。为构造大数据时空主键与后续时空分析进行预处理操作。

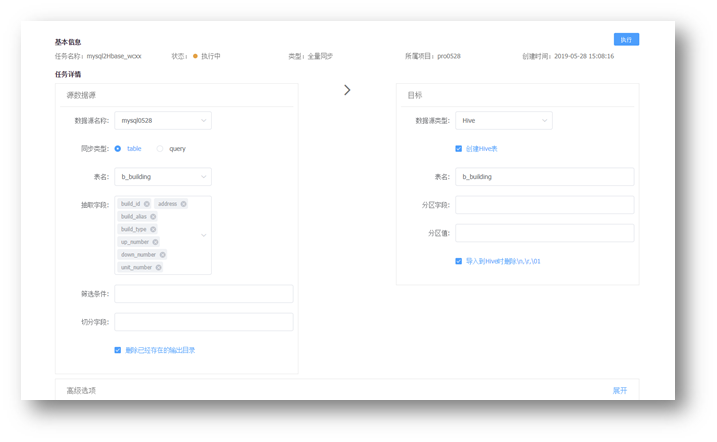

数据同步

提供实现异构数据源的数据同步,通过可视化的配置,能实现增量全量,可以分表,能减少很多技术的实现成本。

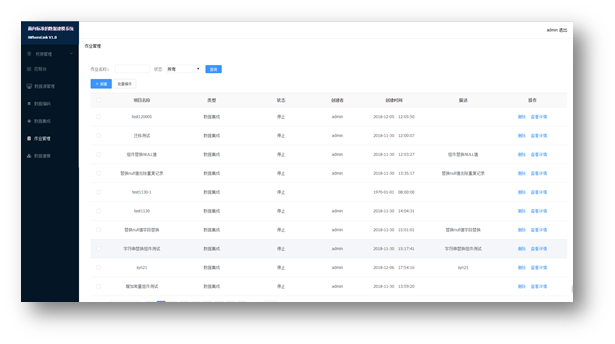

作业管理

主要实现了对数据集成和数据编码、数据同步的作业信息的统一管理和后续维护。

数据地图

数据地图功能可助您实现数据的统一管理和血缘的跟踪。以数据搜索为基础,辅以表使用说明、数据类目、数据血缘等工具,帮助数据表的使用者和拥有者们更好地管理数据、协作开发。

应用场景

政务大数据迁移

大数据技术应用的早期,很多公司使用 Sqoop 作为数据同步工具就可以满足了MySQL与 Hive之间数据同步的日常开发需求。

随着公司业务发展,数据同步的场景越来越多,主要结构化数据库与大数据中如hive的数据仓库之间的数据同步,Sqoop已经不能完全满足我们的需求。主要痛点如下:

· 多次因Postgres变更引起的数据同步异常。Postgres需要支持读写分离与分表分库模式,而且要兼容可能的数据库迁移、节点宕机以及主从切换。

· 有不少异常是由表结构变更导致。如Postgres或Hive的表结构都可能发生变更,需要兼容多数的表结构不一致情况。

· Postgres读写操作不能影响线上业务,不能触发Postgres的运维告警。

· 希望支持更多的数据源,如Hbase、ES、文本文件。

通过采用DataLink,除了解决以上问题外,还能够收集到更多运行细节,方便日常维护:

· 统计信息采集,例如运行时间、数据量、消耗资源。

· 脏数据校验和上报。

· 提供作业日志,方便监控。

交通大数据网格化关联检索

在日常形成的大量的公共交通轨迹数据中迁移到大数据平台的过程中,由于许多业务需要导入到Hbase中。

Hbase是建立在Hadoop生态之上的数据库,对离线任务支持友好,具有LSM树这种高吞吐数据库结构,可以定时大批量处理任务。但是由于Hbase本身对时空数据没有优化,如何在迁移的过程中,在Hbase的主键中加入时空索引信息是一个待解决问题。

通过采用DataLink,提取需要迁移的源数据中的空间字段,在迁移的过程中对空间字段形成时空网格编码,再存储至Hbase中的主键中,业务中可以通过网格来实现在Hbase中的地理位置查询。

零售业中打通数据通道流程

由于公司各个部门对业务数据的需求,比如进行数据分析、报表展示等等,且公司没有相应的系统、数据仓库满足这些需求,最原始的办法就是把数据提取出来生成excel表发给各个部门,现在已经录入数据库交给了DBA使用,而有些数据分析部门,则需要运维把生产库的数据同步到他们自己的库,并且需要对比如客户的身份证号、手机号等等的数据进行脱敏。这些数据来源分散在不同的机器,不同的数据库实例里,这样就无法使用数据库的多源复制,往往只能用写脚本实现。随着业务的发展,导致堆积到运维部门的同步数据任务越来越多,一个任务对应一个脚本,有的脚本多达数十多张表,脚本超过10个以后,每次同步失败、或者对脚本里的参数进行修改,都要从10多个脚本里的数十个SQL去找,这是一件非常痛苦的事情,耗费时间、没有效率,且容易改错。

采用DataLink,可以查询到同步任务的增删改查、执行的历史日志,DBA自主操作灵活性更大。